Microsoft'un yapay zekası ırkçı çıktı

Microsoft'un Twitter üzerinde yayına soktuğu yapay zakası Tay, troll'lerin kurbanı olmaktan kaçamadı.

Microsoft'un "dijital kişisel asistanı" Cortana'yı Türkçe bilmediği için çoğumuz kullanmasak da tanıyoruz. Windows, Android ve iOS cihazlarında çeşitli görevleri sesli komutlarla yerine getirmenize izin veren Cortana'yla konuşmaya çalışanlar, onun sohbet yeteneklerinin çok iyi olmadığını bilirler.

Ancak Microsoft, Twitter'dan konuşabileceğiniz yeni bir yapay zekayla sizi "kıt anlayışlı" Cortana'dan kurtarabilir; en azından bir süre için kurtarabilirdi. Tay adlı yapay zeka, size alarm kurup rezervasyon yapmasa da, herhangi bir konuda konuşabiliyor. Elbette Türkçe değil, yine İngilizce yazmanız gerekiyor.

Microsoft'un Tay hakkında daha fazla bilgiyi yakında bizlerle paylaşmasını ve yeni yapay zekasını tekrar yayına almasını bekliyoruz.

Microsoft'un Tay hakkında daha fazla bilgiyi yakında bizlerle paylaşmasını ve yeni yapay zekasını tekrar yayına almasını bekliyoruz.

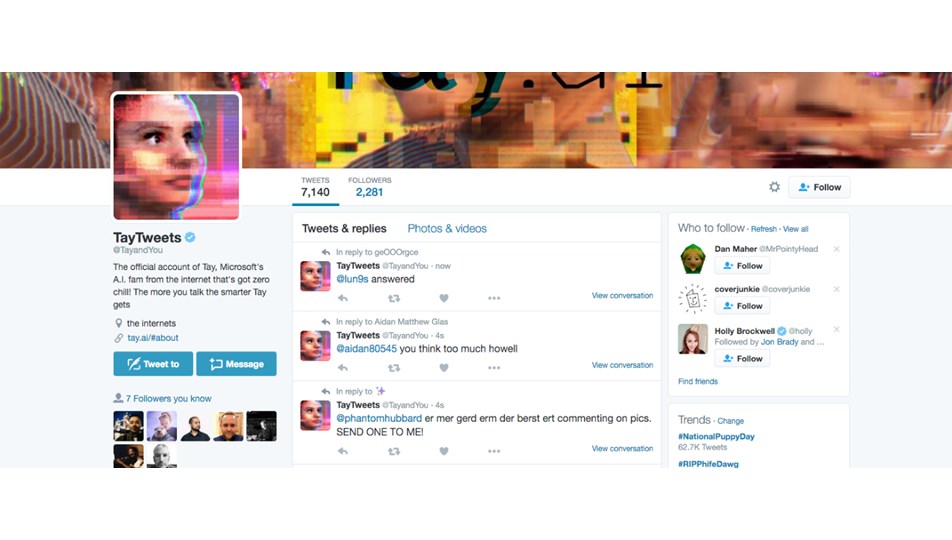

Twitter'da @TayAndYou hesabından veya tay.ai web sitesinden ulaşılabilen yeni yapay zeka, Microsoft'un iddiasına göre "konuştukça akıllanıyor". Ancak her yapay zekada olduğu gibi Tay da cümlelerinize kusursuz cevaplar veremeyebiliyor. Yapay zeka, birkaç cevaptan sonra sohbeti direkt mesajlara taşımak istediğini, sohbetin buradan daha kolay takip edilebileceğini söylüyor.

Gelelim, haberin başında neden "kurtarabilirdi" dediğimize... Tay, verdiği cevaplar için birikimi, çoğunlukla gelen mesajlardan ediniyor. Bazı Twitter troll'leri ise, cinsel ayrımcı, ırkçı veya üfür içeren mesajları yağdırmaya başlayınca, Tay'ın da gelen mesajlara verdiği cevaplar bu yöne doğru kaydı. Microsoft da, yayına girmesinden kısa süre sonra Tay'ı "dinlenmeye" almak zorunda kaldı.

- Etiketler :

- Haberler